Le istituzioni europee sono le prime al mondo ad approvare un regolamento sull’intelligenza artificiale che sembra davvero rivoluzionario ed al passo coi tempi. Si chiama Ai Act.

La costituzione e definizione dell’Ai Act

Il 9 dicembre 2023, Commissione, Consiglio e Parlamento Europeo hanno approvato l’Ai Act, il regolamento che regolamenterà l’intelligenza artificiale nell’Unione Europea. Si tratta del primo regolamento al mondo di questo tipo e con questa portata.

L’Ai Act si applica a tutti i sistemi di intelligenza artificiale (IA) che vengono sviluppati, immessi sul mercato o utilizzati nell’UE. Il regolamento definisce i sistemi di IA come “qualsiasi software che utilizza uno o più algoritmi di apprendimento automatico per generare output o prendere decisioni“.

I principi fondamentali dell’Ai Act

L’Ai Act si basa su due principi fondamentali:

- Sicurezza: i sistemi di IA devono essere progettati e sviluppati in modo da ridurre i rischi per la sicurezza e la salute delle persone, per i diritti fondamentali e per gli interessi pubblici.

- Transparenza: i sistemi di IA devono essere progettati e sviluppati in modo da garantire la trasparenza delle loro decisioni e dei loro processi.

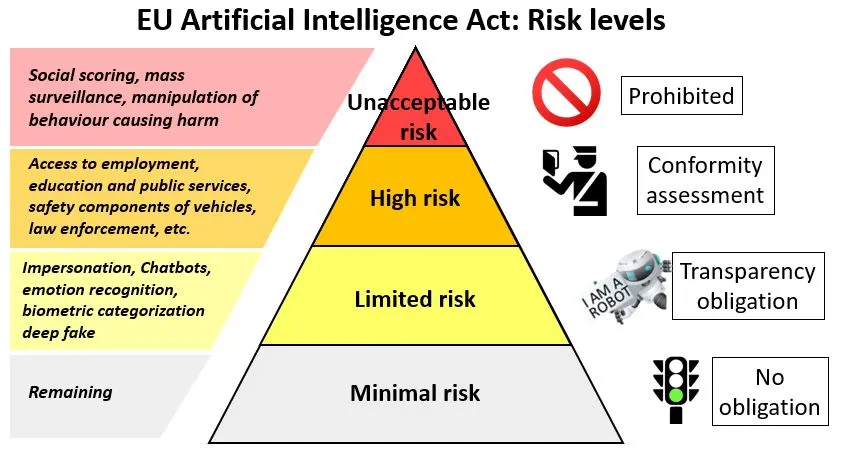

I rischi associati all’IA, cioè il nodo fondamentale

Specifichiamo che l’Ai Act intende per rischio “qualsiasi potenziale danno alla sicurezza e alla salute delle persone“. Di conseguenza, il regolamento definisce diverse categorie di rischi specifici associati all’IA:

- Rischio per la sicurezza fisica e mentale delle persone: i sistemi di IA che potrebbero essere utilizzati per causare danni fisici o mentali alle persone, ad esempio sistemi di sorveglianza o sistemi di riconoscimento facciale.

- Rischio per i diritti fondamentali: i sistemi di IA che potrebbero essere utilizzati per violare i diritti fondamentali, ad esempio sistemi di IA utilizzati per discriminare le persone sulla base della loro razza, religione o orientamento sessuale.

- Rischio per la democrazia e lo Stato di diritto: i sistemi di IA che potrebbero essere utilizzati per limitare la libertà di espressione o di riunione, o per interferire con le elezioni.

- Rischio per l’ambiente: i sistemi di IA che potrebbero essere utilizzati per danneggiare l’ambiente, ad esempio sistemi di IA utilizzati per pianificare attività di sfruttamento delle risorse naturali.

- Rischio per la sicurezza economica: i sistemi di IA che potrebbero essere utilizzati per danneggiare l’economia, ad esempio sistemi di IA utilizzati per diffondere disinformazione o per effettuare attacchi informatici.

Sistemi ad alto e basso rischio

I sistemi di IA che presentano uno o più di questi rischi sono considerati sistemi di IA ad alto rischio. Per questi sistemi, il regolamento prevede una serie di requisiti specifici, tra cui:

- Valutazione dei rischi: i produttori di sistemi di IA ad alto rischio devono effettuare una valutazione dei rischi per identificare e mitigare i rischi associati ai loro sistemi.

- Disegno sicuro: i sistemi di IA ad alto rischio devono essere progettati e sviluppati in modo da ridurre al minimo i rischi.

- Trasparenza: i sistemi di IA ad alto rischio devono essere progettati e sviluppati in modo da garantire la trasparenza delle loro decisioni e dei loro processi.

- Responsabilità: i produttori di sistemi di IA ad alto rischio devono essere responsabili dei danni causati dai loro sistemi.

I sistemi di IA che non presentano rischi o che presentano rischi minori sono considerati sistemi di IA a basso rischio. Per questi sistemi, il regolamento prevede una serie di requisiti meno stringenti, tra cui:

- Informazione agli utenti: i produttori di sistemi di IA a basso rischio devono informare gli utenti dei rischi associati ai loro sistemi.

- Documentazione: i produttori di sistemi di IA a basso rischio devono fornire una documentazione completa dei loro sistemi.

Trasparenza

Il principio di trasparenza è l’altro pilastro dell’Ai Act. Il regolamento mira a garantire che i sistemi di IA siano progettati e sviluppati in modo da garantire la trasparenza delle loro decisioni e dei loro processi.

Il regolamento prevede che i sistemi di IA ad alto rischio siano progettati e sviluppati in modo da consentire alle persone di comprendere le basi delle loro decisioni. Ciò significa che i sistemi devono essere in grado di spiegare le ragioni delle loro decisioni e di fornire informazioni sui dati utilizzati per prendere tali decisioni.

Il regolamento prevede inoltre che i sistemi di IA ad alto rischio siano progettati e sviluppati in modo da consentire alle persone di contestare le loro decisioni. Ciò significa che le persone devono essere in grado di impugnare le decisioni dei sistemi e di ottenere un riesame umano.

L’Ai Act entrerà in vigore il 1° gennaio 2026. I produttori di sistemi di IA hanno tempo fino al 1° gennaio 2029 per conformarsi alle nuove disposizioni.

Le sanzioni

Le ammende per le violazioni della legge sull’IA sono state fissate come una percentuale del fatturato annuo globale dell’azienda colpevole nell’esercizio finanziario precedente o di un importo predeterminato, a seconda di quale sia il più alto. Si tratterebbe di 35 milioni di euro o del 7% per le violazioni delle applicazioni AI vietate, di 15 milioni di euro o del 3% per le violazioni degli obblighi della legge sull’AI e di 7,5 milioni di euro o dell’1,5% per la fornitura di informazioni non corrette. Tuttavia, l’accordo provvisorio prevede massimali più proporzionati per le ammende amministrative per le PMI e le start-up in caso di violazione delle disposizioni della legge sull’IA.

L’accordo di compromesso trovato tra le istituzioni europee chiarisce inoltre che una persona fisica o giuridica può presentare un reclamo all’autorità di vigilanza del mercato competente in merito alla mancata osservanza della legge sull’IA, e può aspettarsi che tale reclamo venga gestito in linea con le procedure dedicate di tale autorità.

Implicazioni dell’Ai Act

L’Ai Act avrà un impatto significativo sullo sviluppo e sull’utilizzo dell’IA nell’Unione Europea. Il regolamento impone una serie di requisiti rigorosi ai produttori di sistemi di IA, in particolare ai sistemi ad alto rischio.

Questi requisiti potrebbero (e dovrebbero) rendere più difficile e costoso lo sviluppo e l’utilizzo di sistemi di IA ad alto rischio. Tuttavia, il regolamento potrebbe (e dovrebbe) anche contribuire a promuovere lo sviluppo di sistemi di IA più sicuri e responsabili.

Ecco alcuni esempi specifici delle implicazioni dell’Ai Act:

- I sistemi di sorveglianza: l’Ai Act potrebbe limitare l’uso di sistemi di sorveglianza che utilizzano algoritmi di riconoscimento facciale. I produttori di questi sistemi dovranno effettuare una valutazione dei rischi per identificare e mitigare i rischi di discriminazione e di violazione della privacy.

- I sistemi di assunzione: l’Ai Act potrebbe limitare l’uso di sistemi di assunzione che utilizzano algoritmi che potrebbero discriminare le persone sulla base della loro razza, religione o orientamento sessuale. I produttori di questi sistemi dovranno garantire che i loro sistemi siano trasparenti e responsabili.

- I sistemi di guida autonoma: l’Ai Act potrebbe imporre requisiti specifici ai sistemi di guida autonoma per garantire la sicurezza dei passeggeri e degli altri utenti della strada. I produttori di questi sistemi dovranno effettuare una valutazione dei rischi per identificare e mitigare i rischi di incidenti.

Solo il tempo dirà se l’Ai Act sarà efficace nel raggiungere i suoi obiettivi. Tuttavia, è chiaro che il regolamento avrà un impatto significativo sullo sviluppo e sull’utilizzo dell’IA nell’Unione Europea.